Когда Вы создаете свой сайт, непременно столкнетесь с понятием «индексация сайта в поисковых системах». В этой статье мы с вами постараемся разобраться во всех тонкостях. Что такое индексация, зачем она нужна и как сделать, чтобы она проходила быстро.

Индексация — это добавление информации о новом сайте или странице в базу данных поисковой системы. Поисковая база – это подобме с библиотечным каталогом, где внесены данные о книгах. Только здесь будет одна разница, это вместо книг здесь страницы сайта. Веб-страницу в поиске будет не видно, пока информация об этой странице не окажется в базе. Но просто добавление страницы в базу недостаточно. Поисковой системе нужно понять на сколько эта страница полезная для пользователя. Происходит множество проверок со стороны поисковой системы и Ваша страница наконец-то появляется в поиске. Только будет одна проблемка… Страница будет в поисковой выдаче на 50-150 позиции. А далее нужно время, но это тема отдельной статьи.

Как все же проходит индексация сайта?

Первоначально разберем, как происходит индексирование отдельных страниц сайта.

- Краулер (поисковый робот) обходит сайт и находит новую веб-страницу.

- Все данные хорошо анализируются: очищается контент от ненужной информации и формируется лексем. Лексем — множество всех грамматических форм и значений слова в русском языке.

- Лексемы расставляются в алфавитном порядке и вся собранная информация упорядочивается,. Так же поисковой робот после обработки данных распределяет полученную информацию по тематикам.

Появляется индексная запись.

Индексация сайта, ее алгоритмы и технологии

Давайте будем честны, точные алгоритмы по которым индексируется сайт – конфиденциальная информация. Над поисковыми роботами работают целые отделы программистов. Именно по этому в данной статье мы поговорим про известные алгоритмы (базовые). Безусловно нужно сказать, что Яндекс и Гугл в первую очередь берут базовую информацию из разных источников. Яндекс из robots.txt, а Google из sitemap.xml.

Индексация сайта в Гугл

Самое большое отличие индексации гугл является использование технологии Mobile-first. По этой технологии делается первоочередное сканирование и индексация именно мобильной версии сайта. Mobile-first это по сути искусственный интеллект. Разумеется, если ваша веб-страница при показе на мобильных устройствах будет содержать мало полезной информации, то она может даже не попасть в индекс. Стоит отметить, что Google еще и подтверждает наличие «краулингового бюджета». Краулинговый бюджет — частота посещения сайта поисковым роботом. Соответственно, чем чаще робот посещает Вас сам, тем более вероятно, что новая страница проиндексируется быстрее. Точные данные о формировании краулингового бюджета представители компании не раскрывают. По логике вещей огромное влияние будет иметь частота обновлений и возраст сайта.

Индексация сайта в Яндекс

Что касаемо Яндекса, то основной версией считается десктопная версия сайта. И в первую очередь сканируется именно она. Про краулинговый бюджет представители компании говорят, что его нет. Поэтому индексирование происходит без зависимости от возраста сайта и других показателей. Так же может повлиять количество веб-страниц выложенных в интернет.

Приоритетом в любых поисковых системах будут являться сайты с большой посещаемостью. Соответственно, чем выше посещаемость, тем быстрее новая веб-страница будет проиндексированна. При создании веб-страниц очень важно обратить внимание на вес страниц и документов. Так как Яндекс не индексирует документы с весом более 10 Мб.

Как настроить индексацию сайта?

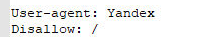

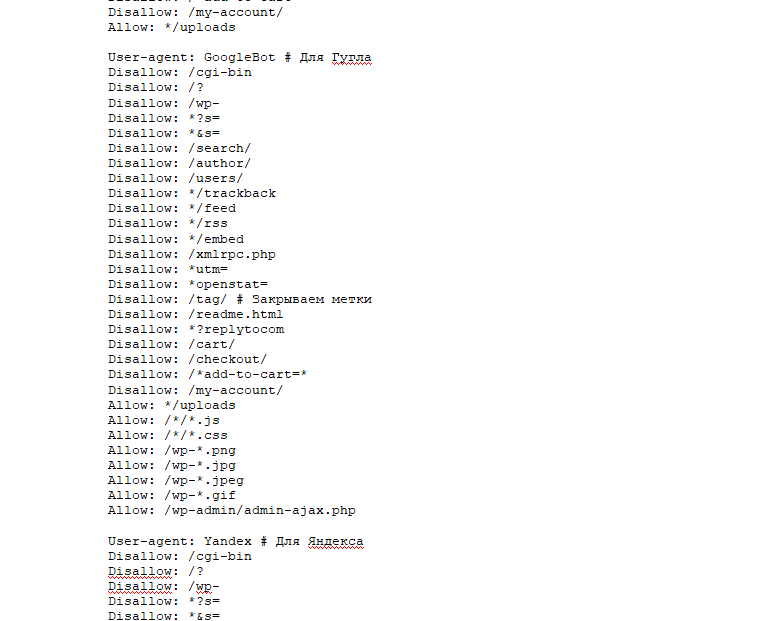

В общем и целом сайт будет индексироваться самостоятельно. И это даже если вы не будете ничего предпринимать для этого. Все происходит автоматически и занимает порядка 4х недель. Но если Вы разберетесь в азах индексации, то получите реально быструю и очень надежную индексацию. А так же при возникновении проблем с сайтом Вы будете понимать, в чем причина. Давайте все же подробнее. Первое, что мы делаем — это создаем правильный файл robots.txt. Конечно при установке хорошей темы, этот файл подгружается автоматически, но можно его доработать. Как минимум нужно понимать суть, какие директивы используются в этом файле. На фото показан robots.txt. для сайта на WP:

В таблице ниже Вы разберетесь с основными параметрами robots.txt:

| Директива | Зачем используется |

| User-agent: | Правила для поискового робота, для которого они установлены |

| Disallow: | Запрещает индексацию назначенных веб-страниц |

| sitemap: | Путь к файлу sitemap.xml (о нем чуть позже) |

| Clean-param: | Указывает на веб-страницы, где часть ссылок не стоит учитывать |

| Allow: | Разрешает индексацию страницы |

| Crawl-delay: | Показывает поисковому роботу минимальное время ожидания между посещением предыдущей и следующей страницы сайта |

Далее для хорошей индексации мы делаем файл sitemap.xml. По факту это самая обычная карта сайта. В данный файл вносятся все страницы, которые должны быть проиндексированы. Сделано это для упрощения считывания данных поисковыми роботами.

Остался только один вопрос, как создать файл sitemap.xml. И все решение зависит от CMS вашего сайта. В моем случае данный файл создавался автоматически при установке плагина YoastSeo на базе WP. Если же у вас не очень популярный «движок», то придется делать все руками. Для этого рекомендую воспользоваться онлайн-генератором: допустим mySitemapgenerator. Вводим url сайта и через некоторое время получаем готовый файл.

Как запретить индексацию страниц?

В редких случаях может потребоваться специально запретить индексацию. Допустим как вариант, Вы только создаете страницу и на ней еще нет нужной информации. А может вообще сайт только в разработке и все веб-страницы — тестовые и еще недоработанные. Есть несколько способов, для того чтобы «спрятать» страницу от роботов поисковых систем.

Первый способ

Допустим Вам необходимо скрыть всего лишь один документ, то разумно добавить в код страницы метатег Noindex. Данная команда дает команду поисковому роботу не индексировать документ. Размещают как правило его между тегами <head>. Пример:<meta name=»robots» content=»noindex» /> Множество CMS позволяет использовать данный метод за одно мгновение, предлагая уже готовые решения. У WP имеется отдельная строчка в настройках редактора Настройки-Чтение – и поставить галочку в конце.

Второй способ

Редактирование нашего любимого файла robots.txt. Есть несколько приемов закрытия страниц от индексирования.

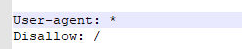

Полное закрытие от прохождения индексации

Закрытие от прохождения индексации определенной поисковой системы Так же Вы можете ограничить индексацию отдельной страницы путем написания в нижней строчке ее url.